私はビートルズが大好きですが、生まれる5年前には解散してしまい、当然ながら「リアルタイム」では体験できていません。

そんな世代のファンにとって、1995〜6年にかけて「ビートルズ・アンソロジー」プロジェクトにおいて、ジョン・レノンの遺したテープを元に仕上げられた「Free as a Bird」「Real Love」の2曲がリリースされ、「新曲リリース」をリアルタイムで体験できたのは感動的な出来事でした(賛否あるようですが、私は2曲とも大好き!)

その当時から「〝もう1曲〟作業したが、録音状態が悪く断念した」という話は伝わっていましたが、そこから30年近くたった今年の11/2、現代のAI技術によってクリーン化する事に成功したジョンのヴォーカル素材を元にした最後の新曲「Now And Then」がリリースされました!

リリースが発表された時「AIを使った」という事で、すでに故人のジョン・レノンやジョージ・ハリスンの歌や演奏をヴァーチャル合成したのではとの誤解で批判が出ましたが、使われたのは「音同士を分離する技術」。録音された時期に数十年の開きはありますが、曲中の音声はメンバーの演奏そのものです。

実はこうした、AIに「これは◯◯の音声」と認識させて分離する技術はすごいスピードで進化しており、私も普段から仕事上で多用しています。

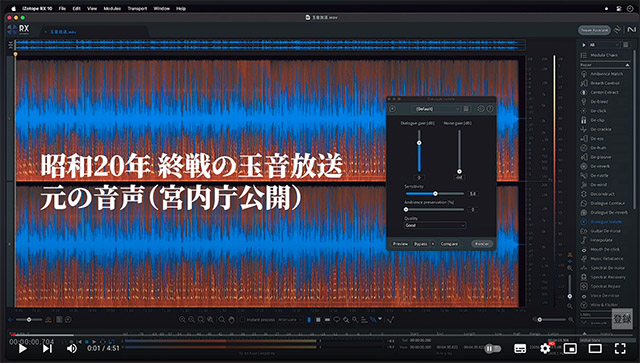

ちょっとデモとして、宮内庁が公開している、昭和20年の昭和天皇による終戦の玉音放送音声から、ノイズを取り除く動画を録ってみました。

いかがでしょう、かなりクリアになって驚かれた方も多いと思います。多分当時の日本でも、玉音放送をこれだけクリアに聴いた人は(レコードやラジオに乗った時点で劣化するので)録音を担当していたNHKの技官以外にいなかったでしょう。

映像の場合、画面の外にあるものは(ガラス等への映り込みをのぞき)全く入りませんが、音は四方八方からマイクに飛び込んで来ます。もしこの先、ごく微弱な音声もクリアに抽出できるようになれば、例えば騒然とする事件現場の記録などから、これまでの定説を完全に覆す発見が得られる可能性もあるでしょう。

最近は「生成系」のAIが大注目されていますが、個人的には、こうした分離技術による「過去からの発見」により大きく心が踊っています。